实例介绍

【实例简介】

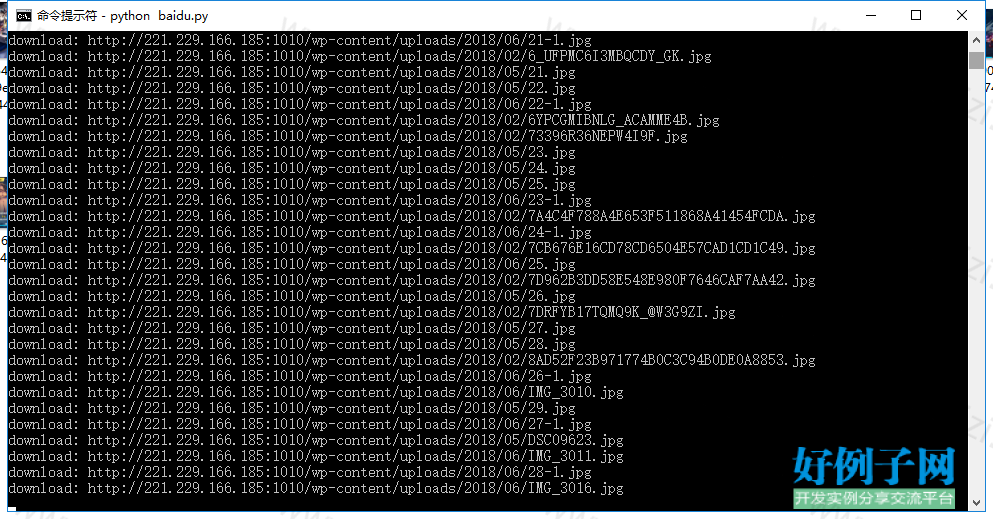

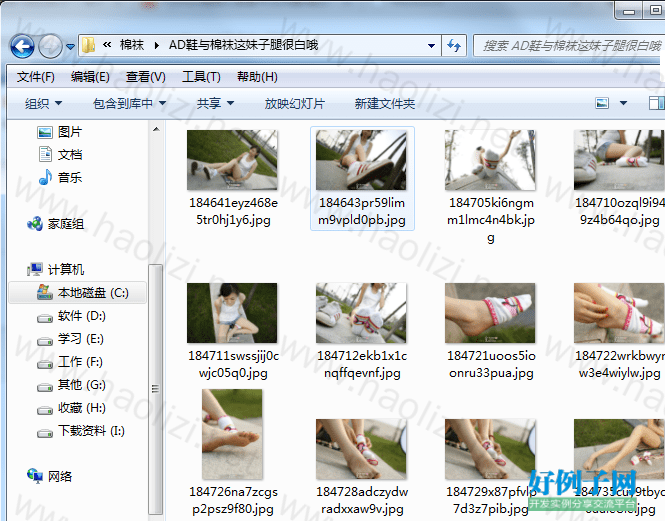

【实例截图】

【核心代码】

import requests

from lxml import etree

import re

import os

from multiprocessing.dummy import Pool as ThreadPool

def gethtml(url,encode): #获取网页源码

r = requests.get(url)

r.encoding = encode

return r.text

def filterFName(FName): #文件名过滤特殊字符

rstr = r"[\/\\\:\*\?\"\<\>\|]"

new_name = re.sub(rstr, "_", FName)

return new_name

def mkdir(path): #创建文件夹

path = path.strip()

isExists = os.path.exists(path)

if not isExists:

os.makedirs(path)

def geturl(url): #获取网站各个分类链接、分类名称

html = gethtml(url,'utf-8')

ehtml = etree.HTML(html)

nurl = ehtml.xpath('//*[@id="chenxing_menu"]/li/a/@href')

ntitle = ehtml.xpath('//*[@id="chenxing_menu"]/li/a/text()')

urldata=[]

for i in range(1,len(nurl)-1):

urldata.append(nurl[i] '|' ntitle[i])

return urldata

def downPic(url,savepath): #下载图片

picname=url.split('/')[-1]

print('download: ' url)

picdata = requests.get(url)

with open(savepath picname, 'wb') as file:

file.write(picdata.content)

def getdata(ulist): #根据网站分类链接、名称进一步解析 这段代码是下载图片主体代码

url = ulist.split('|')[0]

til = ulist.split('|')[1]

html = gethtml(url,'utf-8')

ehtml = etree.HTML(html)

count = ''.join(ehtml.xpath('//*[@class="more r"]/em/text()'))

page = int(count) // 20

if int(count) % 20 > 0 :

page =1

for i in range(1,page 1):#获取各分类下面所有图集链接

nurl = url 'page/' str(i)

html = gethtml(nurl, 'utf-8')

ehtml = etree.HTML(html)

lvurl = ehtml.xpath('//*[@class="img"]/@href')

for j in lvurl: #获取每个图集页数和链接

html = gethtml(j, 'utf-8')

ehtml = etree.HTML(html)

lvurl = ''.join(ehtml.xpath('//*[@id="imagecx"]/h1/span/text()')) # 获取图集页数

title = ''.join(ehtml.xpath('//*[@id="imagecx"]/h1/text()')) #获取图集名称

title = title.replace('()','')

lvurl = lvurl.replace('1/','')

path = savepath '\\' til '\\' filterFName(title) '\\'

mkdir(path)

for k in range(1,int(lvurl)): #获取每个图集页面的图片

zurl = j.replace('.html','_' str(k) '.html')

html = gethtml(zurl,'urf-8')

ehtml = etree.HTML(html)

picurl = ehtml.xpath('//*[@class="image_cx_cont"]/img/@src')

for l in picurl:

downPic(l,path) #下载图片

if __name__ == '__main__':

url = 'http://mzsock.com'

savepath='C:\\mzsock' #保存位置

urllist=geturl(url)

pool = ThreadPool(4)

results = pool.map(getdata, urllist)

pool.close()

pool.join()

print('任务全部完成~!')

好例子网口号:伸出你的我的手 — 分享!

相关软件

小贴士

感谢您为本站写下的评论,您的评论对其它用户来说具有重要的参考价值,所以请认真填写。

- 类似“顶”、“沙发”之类没有营养的文字,对勤劳贡献的楼主来说是令人沮丧的反馈信息。

- 相信您也不想看到一排文字/表情墙,所以请不要反馈意义不大的重复字符,也请尽量不要纯表情的回复。

- 提问之前请再仔细看一遍楼主的说明,或许是您遗漏了。

- 请勿到处挖坑绊人、招贴广告。既占空间让人厌烦,又没人会搭理,于人于己都无利。

关于好例子网

本站旨在为广大IT学习爱好者提供一个非营利性互相学习交流分享平台。本站所有资源都可以被免费获取学习研究。本站资源来自网友分享,对搜索内容的合法性不具有预见性、识别性、控制性,仅供学习研究,请务必在下载后24小时内给予删除,不得用于其他任何用途,否则后果自负。基于互联网的特殊性,平台无法对用户传输的作品、信息、内容的权属或合法性、安全性、合规性、真实性、科学性、完整权、有效性等进行实质审查;无论平台是否已进行审查,用户均应自行承担因其传输的作品、信息、内容而可能或已经产生的侵权或权属纠纷等法律责任。本站所有资源不代表本站的观点或立场,基于网友分享,根据中国法律《信息网络传播权保护条例》第二十二与二十三条之规定,若资源存在侵权或相关问题请联系本站客服人员,点此联系我们。关于更多版权及免责申明参见 版权及免责申明

网友评论

我要评论