实例介绍

【实例简介】自然语言处理领域经典综述教材《Speech and Language Processing 》,中文名《自然语言处理综述》第三版发布。该书由NLP领域的大牛,斯坦福大学 Daniel Jurafsky教授和科罗拉多大学的 James H. Martin 教授等人共同编写。Daniel Jurafsky是斯坦福大学计算机科学教授,主要研究方向是计算语言学和自然语言处理。James H. Martin 是科罗拉多大学博尔德分校计算机科学系一名教授,两位教授都是NLP领域知名学者。

【实例截图】

【核心代码】

【目录】

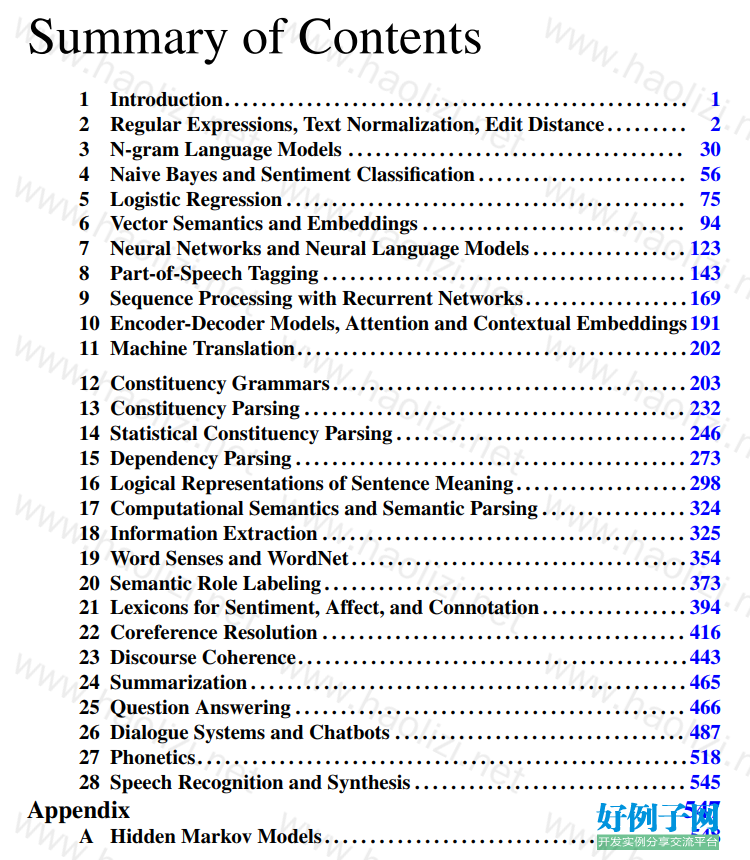

Summary of Contents 1 Introduction. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1 2 Regular Expressions, Text Normalization, Edit Distance . . . . . . . . . 2 3 N-gram Language Models . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30 4 Naive Bayes and Sentiment Classification . . . . . . . . . . . . . . . . . . . . . . . 56 5 Logistic Regression . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 75 6 Vector Semantics and Embeddings . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94 7 Neural Networks and Neural Language Models . . . . . . . . . . . . . . . . . 123 8 Part-of-Speech Tagging . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 143 9 Sequence Processing with Recurrent Networks . . . . . . . . . . . . . . . . . . 169 10 Encoder-Decoder Models, Attention and Contextual Embeddings 191 11 Machine Translation. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 202 12 Constituency Grammars . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 203 13 Constituency Parsing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 232 14 Statistical Constituency Parsing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 246 15 Dependency Parsing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 273 16 Logical Representations of Sentence Meaning . . . . . . . . . . . . . . . . . . . 298 17 Computational Semantics and Semantic Parsing . . . . . . . . . . . . . . . . 324 18 Information Extraction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 325 19 Word Senses and WordNet . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 354 20 Semantic Role Labeling . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 373 21 Lexicons for Sentiment, Affect, and Connotation . . . . . . . . . . . . . . . . 394 22 Coreference Resolution . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 416 23 Discourse Coherence. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 443 24 Summarization . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 465 25 Question Answering . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 466 26 Dialogue Systems and Chatbots . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 487 27 Phonetics. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 518 28 Speech Recognition and Synthesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 545 Appendix 547 A Hidden Markov Models . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 548 2 Contents 1 Introduction 1 2 Regular Expressions, Text Normalization, Edit Distance 2 2.1 Regular Expressions . . . . . . . . . . . . . . . . . . . . . . . . . 3 2.2 Words . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11 2.3 Corpora . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13 2.4 Text Normalization . . . . . . . . . . . . . . . . . . . . . . . . . 14 2.5 Minimum Edit Distance . . . . . . . . . . . . . . . . . . . . . . . 23 2.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 27 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28 3 N-gram Language Models 30 3.1 N-Grams . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31 3.2 Evaluating Language Models . . . . . . . . . . . . . . . . . . . . 36 3.3 Generalization and Zeros . . . . . . . . . . . . . . . . . . . . . . 38 3.4 Smoothing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42 3.5 Kneser-Ney Smoothing . . . . . . . . . . . . . . . . . . . . . . . 46 3.6 The Web and Stupid Backoff . . . . . . . . . . . . . . . . . . . . 48 3.7 Advanced: Perplexity’s Relation to Entropy . . . . . . . . . . . . 49 3.8 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 53 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54 4 Naive Bayes and Sentiment Classification 56 4.1 Naive Bayes Classifiers . . . . . . . . . . . . . . . . . . . . . . . 58 4.2 Training the Naive Bayes Classifier . . . . . . . . . . . . . . . . . 60 4.3 Worked example . . . . . . . . . . . . . . . . . . . . . . . . . . . 62 4.4 Optimizing for Sentiment Analysis . . . . . . . . . . . . . . . . . 62 4.5 Naive Bayes for other text classification tasks . . . . . . . . . . . 64 4.6 Naive Bayes as a Language Model . . . . . . . . . . . . . . . . . 65 4.7 Evaluation: Precision, Recall, F-measure . . . . . . . . . . . . . . 66 4.8 Test sets and Cross-validation . . . . . . . . . . . . . . . . . . . . 69 4.9 Statistical Significance Testing . . . . . . . . . . . . . . . . . . . 69 4.10 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 72 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73 5 Logistic Regression 75 5.1 Classification: the sigmoid . . . . . . . . . . . . . . . . . . . . . 76 5.2 Learning in Logistic Regression . . . . . . . . . . . . . . . . . . . 80 5.3 The cross-entropy loss function . . . . . . . . . . . . . . . . . . . 81 5.4 Gradient Descent . . . . . . . . . . . . . . . . . . . . . . . . . . 82 5.5 Regularization . . . . . . . . . . . . . . . . . . . . . . . . . . . . 87 5.6 Multinomial logistic regression . . . . . . . . . . . . . . . . . . . 89 5.7 Interpreting models . . . . . . . . . . . . . . . . . . . . . . . . . 91 5.8 Advanced: Deriving the Gradient Equation . . . . . . . . . . . . . 91 5.9 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 92 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 93 3 4 CONTENTS Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93 6 Vector Semantics and Embeddings 94 6.1 Lexical Semantics . . . . . . . . . . . . . . . . . . . . . . . . . . 95 6.2 Vector Semantics . . . . . . . . . . . . . . . . . . . . . . . . . . 98 6.3 Words and Vectors . . . . . . . . . . . . . . . . . . . . . . . . . . 100 6.4 Cosine for measuring similarity . . . . . . . . . . . . . . . . . . . 103 6.5 TF-IDF: Weighing terms in the vector . . . . . . . . . . . . . . . 105 6.6 Applications of the tf-idf vector model . . . . . . . . . . . . . . . 107 6.7 Optional: Pointwise Mutual Information (PMI) . . . . . . . . . . . 108 6.8 Word2vec . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110 6.9 Visualizing Embeddings . . . . . . . . . . . . . . . . . . . . . . . 115 6.10 Semantic properties of embeddings . . . . . . . . . . . . . . . . . 115 6.11 Bias and Embeddings . . . . . . . . . . . . . . . . . . . . . . . . 117 6.12 Evaluating Vector Models . . . . . . . . . . . . . . . . . . . . . . 118 6.13 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 119 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 120 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122 7 Neural Networks and Neural Language Models 123 7.1 Units . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124 7.2 The XOR problem . . . . . . . . . . . . . . . . . . . . . . . . . . 126 7.3 Feed-Forward Neural Networks . . . . . . . . . . . . . . . . . . . 129 7.4 Training Neural Nets . . . . . . . . . . . . . . . . . . . . . . . . 132 7.5 Neural Language Models . . . . . . . . . . . . . . . . . . . . . . 137 7.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 141 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 141 8 Part-of-Speech Tagging 143 8.1 (Mostly) English Word Classes . . . . . . . . . . . . . . . . . . . 143 8.2 The Penn Treebank Part-of-Speech Tagset . . . . . . . . . . . . . 146 8.3 Part-of-Speech Tagging . . . . . . . . . . . . . . . . . . . . . . . 148 8.4 HMM Part-of-Speech Tagging . . . . . . . . . . . . . . . . . . . 149 8.5 Maximum Entropy Markov Models . . . . . . . . . . . . . . . . . 159 8.6 Bidirectionality . . . . . . . . . . . . . . . . . . . . . . . . . . . 163 8.7 Part-of-Speech Tagging for Morphological Rich Languages . . . . 164 8.8 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 165 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 166 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 167 9 Sequence Processing with Recurrent Networks 169 9.1 Simple Recurrent Neural Networks . . . . . . . . . . . . . . . . . 170 9.2 Applications of Recurrent Neural Networks . . . . . . . . . . . . 176 9.3 Deep Networks: Stacked and Bidirectional RNNs . . . . . . . . . 181 9.4 Managing Context in RNNs: LSTMs and GRUs . . . . . . . . . . 183 9.5 Words, Subwords and Characters . . . . . . . . . . . . . . . . . . 187 9.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 189 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 190 10 Encoder-Decoder Models, Attention and Contextual Embeddings 191 10.1 Neural Language Models and Generation Revisited . . . . . . . . 191 10.2 Encoder-Decoder Networks . . . . . . . . . . . . . . . . . . . . . 194 CONTENTS 5 10.3 Attention . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 199 10.4 Applications of Encoder-Decoder Networks . . . . . . . . . . . . 200 10.5 Self-Attention and Transformer Networks . . . . . . . . . . . . . 200 10.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 201 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 201 11 Machine Translation 202 12 Constituency Grammars 203 12.1 Constituency . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 204 12.2 Context-Free Grammars . . . . . . . . . . . . . . . . . . . . . . . 204 12.3 Some Grammar Rules for English . . . . . . . . . . . . . . . . . . 209 12.4 Treebanks . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 216 12.5 Grammar Equivalence and Normal Form . . . . . . . . . . . . . . 222 12.6 Lexicalized Grammars . . . . . . . . . . . . . . . . . . . . . . . . 223 12.7 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 228 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 229 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 230 13 Constituency Parsing 232 13.1 Ambiguity . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 232 13.2 CKY Parsing: A Dynamic Programming Approach . . . . . . . . 234 13.3 Partial Parsing . . . . . . . . . . . . . . . . . . . . . . . . . . . . 240 13.4 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 243 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 243 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 244 14 Statistical Constituency Parsing 246 14.1 Probabilistic Context-Free Grammars . . . . . . . . . . . . . . . . 246 14.2 Probabilistic CKY Parsing of PCFGs . . . . . . . . . . . . . . . . 251 14.3 Ways to Learn PCFG Rule Probabilities . . . . . . . . . . . . . . 253 14.4 Problems with PCFGs . . . . . . . . . . . . . . . . . . . . . . . . 253 14.5 Improving PCFGs by Splitting Non-Terminals . . . . . . . . . . . 256 14.6 Probabilistic Lexicalized CFGs . . . . . . . . . . . . . . . . . . . 258 14.7 Probabilistic CCG Parsing . . . . . . . . . . . . . . . . . . . . . . 262 14.8 Evaluating Parsers . . . . . . . . . . . . . . . . . . . . . . . . . . 268 14.9 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 270 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 271 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 272 15 Dependency Parsing 273 15.1 Dependency Relations . . . . . . . . . . . . . . . . . . . . . . . . 274 15.2 Dependency Formalisms . . . . . . . . . . . . . . . . . . . . . . . 276 15.3 Dependency Treebanks . . . . . . . . . . . . . . . . . . . . . . . 277 15.4 Transition-Based Dependency Parsing . . . . . . . . . . . . . . . 278 15.5 Graph-Based Dependency Parsing . . . . . . . . . . . . . . . . . 289 15.6 Evaluation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 294 15.7 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 295 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 295 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 297 16 Logical Representations of Sentence Meaning 298 6 CONTENTS 16.1 Computational Desiderata for Representations . . . . . . . . . . . 299 16.2 Model-Theoretic Semantics . . . . . . . . . . . . . . . . . . . . . 301 16.3 First-Order Logic . . . . . . . . . . . . . . . . . . . . . . . . . . 304 16.4 Event and State Representations . . . . . . . . . . . . . . . . . . . 311 16.5 Description Logics . . . . . . . . . . . . . . . . . . . . . . . . . . 316 16.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 321 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 322 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 323 17 Computational Semantics and Semantic Parsing 324 18 Information Extraction 325 18.1 Named Entity Recognition . . . . . . . . . . . . . . . . . . . . . 326 18.2 Relation Extraction . . . . . . . . . . . . . . . . . . . . . . . . . 332 18.3 Extracting Times . . . . . . . . . . . . . . . . . . . . . . . . . . . 342 18.4 Extracting Events and their Times . . . . . . . . . . . . . . . . . . 346 18.5 Template Filling . . . . . . . . . . . . . . . . . . . . . . . . . . . 349 18.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 351 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 352 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 353 19 Word Senses and WordNet 354 19.1 Word Senses . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 355 19.2 Relations Between Senses . . . . . . . . . . . . . . . . . . . . . . 357 19.3 WordNet: A Database of Lexical Relations . . . . . . . . . . . . . 359 19.4 Word Sense Disambiguation . . . . . . . . . . . . . . . . . . . . . 362 19.5 Alternate WSD algorithms and Tasks . . . . . . . . . . . . . . . . 365 19.6 Using Thesauruses to Improve Embeddings . . . . . . . . . . . . 368 19.7 Word Sense Induction . . . . . . . . . . . . . . . . . . . . . . . . 368 19.8 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 369 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 370 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 371 20 Semantic Role Labeling 373 20.1 Semantic Roles . . . . . . . . . . . . . . . . . . . . . . . . . . . 374 20.2 Diathesis Alternations . . . . . . . . . . . . . . . . . . . . . . . . 375 20.3 Semantic Roles: Problems with Thematic Roles . . . . . . . . . . 376 20.4 The Proposition Bank . . . . . . . . . . . . . . . . . . . . . . . . 377 20.5 FrameNet . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 378 20.6 Semantic Role Labeling . . . . . . . . . . . . . . . . . . . . . . . 380 20.7 Selectional Restrictions . . . . . . . . . . . . . . . . . . . . . . . 384 20.8 Primitive Decomposition of Predicates . . . . . . . . . . . . . . . 389 20.9 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 390 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 391 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 393 21 Lexicons for Sentiment, Affect, and Connotation 394 21.1 Defining Emotion . . . . . . . . . . . . . . . . . . . . . . . . . . 395 21.2 Available Sentiment and Affect Lexicons . . . . . . . . . . . . . . 397 21.3 Creating Affect Lexicons by Human Labeling . . . . . . . . . . . 398 21.4 Semi-supervised Induction of Affect Lexicons . . . . . . . . . . . 400 21.5 Supervised Learning of Word Sentiment . . . . . . . . . . . . . . 403 CONTENTS 7 21.6 Using Lexicons for Sentiment Recognition . . . . . . . . . . . . . 408 21.7 Other tasks: Personality . . . . . . . . . . . . . . . . . . . . . . . 409 21.8 Affect Recognition . . . . . . . . . . . . . . . . . . . . . . . . . . 410 21.9 Lexicon-based methods for Entity-Centric Affect . . . . . . . . . . 411 21.10 Connotation Frames . . . . . . . . . . . . . . . . . . . . . . . . . 412 21.11 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 413 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 414 22 Coreference Resolution 416 22.1 Coreference Phenomena: Linguistic Background . . . . . . . . . . 419 22.2 Coreference Tasks and Datasets . . . . . . . . . . . . . . . . . . . 424 22.3 Mention Detection . . . . . . . . . . . . . . . . . . . . . . . . . . 425 22.4 Architectures for Coreference Algorithms . . . . . . . . . . . . . 428 22.5 Classifiers using hand-built features . . . . . . . . . . . . . . . . . 430 22.6 A neural mention-ranking algorithm . . . . . . . . . . . . . . . . 431 22.7 Evaluation of Coreference Resolution . . . . . . . . . . . . . . . . 435 22.8 Entity Linking . . . . . . . . . . . . . . . . . . . . . . . . . . . . 436 22.9 Winograd Schema problems . . . . . . . . . . . . . . . . . . . . . 437 22.10 Gender Bias in Coreference . . . . . . . . . . . . . . . . . . . . . 438 22.11 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 440 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 440 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 442 23 Discourse Coherence 443 23.1 Coherence Relations . . . . . . . . . . . . . . . . . . . . . . . . . 445 23.2 Discourse Structure Parsing . . . . . . . . . . . . . . . . . . . . . 448 23.3 Centering and Entity-Based Coherence . . . . . . . . . . . . . . . 452 23.4 Representation learning models for local coherence . . . . . . . . 456 23.5 Global Coherence . . . . . . . . . . . . . . . . . . . . . . . . . . 458 23.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 461 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 462 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 464 24 Summarization 465 25 Question Answering 466 25.1 IR-based Factoid Question Answering . . . . . . . . . . . . . . . 467 25.2 Knowledge-based Question Answering . . . . . . . . . . . . . . . 476 25.3 Using multiple information sources: IBM’s Watson . . . . . . . . 479 25.4 Evaluation of Factoid Answers . . . . . . . . . . . . . . . . . . . 483 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 484 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 486 26 Dialogue Systems and Chatbots 487 26.1 Properties of Human Conversation . . . . . . . . . . . . . . . . . 488 26.2 Chatbots . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 491 26.3 GUS: Simple Frame-based Dialogue Systems . . . . . . . . . . . 498 26.4 The Dialogue-State Architecture . . . . . . . . . . . . . . . . . . 502 26.5 Evaluating Dialogue Systems . . . . . . . . . . . . . . . . . . . . 511 26.6 Dialogue System Design . . . . . . . . . . . . . . . . . . . . . . . 512 26.7 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 514 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 515 8 CONTENTS Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 517 27 Phonetics 518 27.1 Speech Sounds and Phonetic Transcription . . . . . . . . . . . . . 518 27.2 Articulatory Phonetics . . . . . . . . . . . . . . . . . . . . . . . . 520 27.3 Prosodic Prominence: Accent, Stress and Schwa . . . . . . . . . . 525 27.4 Prosodic Structure and Tune . . . . . . . . . . . . . . . . . . . . . 526 27.5 Acoustic Phonetics and Signals . . . . . . . . . . . . . . . . . . . 529 27.6 Phonetic Resources . . . . . . . . . . . . . . . . . . . . . . . . . 539 27.7 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 542 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 543 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 544 28 Speech Recognition and Synthesis 545 Appendix 547 A Hidden Markov Models 548 A.1 Markov Chains . . . . . . . . . . . . . . . . . . . . . . . . . . . . 548 A.2 The Hidden Markov Model . . . . . . . . . . . . . . . . . . . . . 549 A.3 Likelihood Computation: The Forward Algorithm . . . . . . . . . 551 A.4 Decoding: The Viterbi Algorithm . . . . . . . . . . . . . . . . . . 555 A.5 HMM Training: The Forward-Backward Algorithm . . . . . . . . 557 A.6 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 563 Bibliographical and Historical Notes . . . . . . . . . . . . . . . . . . . . 563 Bibliography 565 Author Index 595 Subject Index 605

好例子网口号:伸出你的我的手 — 分享!

小贴士

感谢您为本站写下的评论,您的评论对其它用户来说具有重要的参考价值,所以请认真填写。

- 类似“顶”、“沙发”之类没有营养的文字,对勤劳贡献的楼主来说是令人沮丧的反馈信息。

- 相信您也不想看到一排文字/表情墙,所以请不要反馈意义不大的重复字符,也请尽量不要纯表情的回复。

- 提问之前请再仔细看一遍楼主的说明,或许是您遗漏了。

- 请勿到处挖坑绊人、招贴广告。既占空间让人厌烦,又没人会搭理,于人于己都无利。

关于好例子网

本站旨在为广大IT学习爱好者提供一个非营利性互相学习交流分享平台。本站所有资源都可以被免费获取学习研究。本站资源来自网友分享,对搜索内容的合法性不具有预见性、识别性、控制性,仅供学习研究,请务必在下载后24小时内给予删除,不得用于其他任何用途,否则后果自负。基于互联网的特殊性,平台无法对用户传输的作品、信息、内容的权属或合法性、安全性、合规性、真实性、科学性、完整权、有效性等进行实质审查;无论平台是否已进行审查,用户均应自行承担因其传输的作品、信息、内容而可能或已经产生的侵权或权属纠纷等法律责任。本站所有资源不代表本站的观点或立场,基于网友分享,根据中国法律《信息网络传播权保护条例》第二十二与二十三条之规定,若资源存在侵权或相关问题请联系本站客服人员,点此联系我们。关于更多版权及免责申明参见 版权及免责申明

网友评论

我要评论