实例介绍

【实例简介】

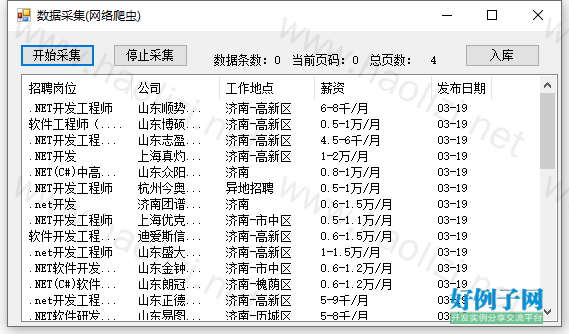

【实例截图】

【核心代码】

using System;

using System.Collections.Generic;

using System.ComponentModel;

using System.Data;

using System.Drawing;

using System.Linq;

using System.Text;

using System.Threading.Tasks;

using System.Windows.Forms;

using HtmlAgilityPack;

using System.Threading;

namespace DataCollect

{

public partial class MainForm : Form

{

public MainForm()

{

InitializeComponent();

}

List<Job> list = new List<Job>();//定义用于存放数据的集合

CancellationTokenSource cts = new CancellationTokenSource();

private void btnCollect_Click(object sender, EventArgs e)

{

cts.Cancel();

//数据采集方法

Task task1 = new Task(Collect);

task1.Start();

// Collect();

}

/// <summary>

/// 数据采集

/// </summary>

private void Collect()

{

int index = 1;

int pageCount = 1;

do

{

var htmlDocument = DataLoad(index);

if (index==1)

{

HtmlNode hnNode= htmlDocument.DocumentNode.SelectSingleNode("//input[@id='hidTotalPage']");

pageCount=int.Parse(hnNode.Attributes["value"].Value);

this.listView1.Invoke(new Action(() => {

this.lblTotalPages.Text = pageCount.ToString();

}));

SetLabel(this.lblTotalPages, pageCount.ToString());

}

Thread.Sleep(2000);

//信息解析

//var htmlDocument = DataLoad(1);//弱类型赋值

HtmlNode hn = htmlDocument.DocumentNode.SelectSingleNode("//div[@class='el title']");

//递归(循环检测还有没有兄弟元素)

GetNode(hn.NextSibling);

index ;

SetLabel(this.lblCurrentNo, index.ToString());

SetLabel(this.lblItems, (50 * pageCount).ToString());

//数据组合

} while (index<pageCount);

}

private void SetLabel(Label lbl,string value)

{

lbl.Invoke(new Action(() =>

{

lbl.Text = value;

}));

}

private void GetNode(HtmlNode parentNode)

{

Thread.Sleep(100);

if(parentNode!=null)

{

if (parentNode.ChildNodes.Count > 0)

{

Job job = new Job();

job.Position = parentNode.ChildNodes[1].InnerText.Replace("\r\n", "").Trim();//只取标签中间的内容

job.Company = parentNode.ChildNodes[3].InnerText;

job.Address = parentNode.ChildNodes[5].InnerText;

job.Salary = parentNode.ChildNodes[7].InnerText;

job.CreateTime = parentNode.ChildNodes[9].InnerText;

list.Add(job);//添加到集合

this.listView1.Invoke(new Action(()=> {

//创建控件对象

ListViewItem lvi = new ListViewItem();

lvi.Text = job.Position;

lvi.SubItems.AddRange(new string[] {job.Company, job.Address, job.Salary, job.CreateTime });

//数据添加到界面的控件

this.listView1.Items.Add(lvi);

}));

}

}

//判断到分页阶段

if(parentNode.NextSibling.Attributes["class"] != null &&

parentNode.NextSibling.Attributes["class"].Value == "dw_page")

{

return;//结束

}

GetNode(parentNode.NextSibling);//调用自己

}

private HtmlAgilityPack.HtmlDocument DataLoad(int _index)

{

HtmlWeb htmlWeb = new HtmlWeb();//创建Html解析对象

htmlWeb.OverrideEncoding = Encoding.GetEncoding("gbk");

string url = $"https://search.51job.com/list/120200,000000,0000,00,9,99,.net,2,{_index}.html";

return htmlWeb.Load(url);

}

private void btnStop_Click(object sender, EventArgs e)

{

cts.Cancel();

}

}

}

好例子网口号:伸出你的我的手 — 分享!

网友评论

小贴士

感谢您为本站写下的评论,您的评论对其它用户来说具有重要的参考价值,所以请认真填写。

- 类似“顶”、“沙发”之类没有营养的文字,对勤劳贡献的楼主来说是令人沮丧的反馈信息。

- 相信您也不想看到一排文字/表情墙,所以请不要反馈意义不大的重复字符,也请尽量不要纯表情的回复。

- 提问之前请再仔细看一遍楼主的说明,或许是您遗漏了。

- 请勿到处挖坑绊人、招贴广告。既占空间让人厌烦,又没人会搭理,于人于己都无利。

关于好例子网

本站旨在为广大IT学习爱好者提供一个非营利性互相学习交流分享平台。本站所有资源都可以被免费获取学习研究。本站资源来自网友分享,对搜索内容的合法性不具有预见性、识别性、控制性,仅供学习研究,请务必在下载后24小时内给予删除,不得用于其他任何用途,否则后果自负。基于互联网的特殊性,平台无法对用户传输的作品、信息、内容的权属或合法性、安全性、合规性、真实性、科学性、完整权、有效性等进行实质审查;无论平台是否已进行审查,用户均应自行承担因其传输的作品、信息、内容而可能或已经产生的侵权或权属纠纷等法律责任。本站所有资源不代表本站的观点或立场,基于网友分享,根据中国法律《信息网络传播权保护条例》第二十二与二十三条之规定,若资源存在侵权或相关问题请联系本站客服人员,点此联系我们。关于更多版权及免责申明参见 版权及免责申明

支持(0) 盖楼(回复)

支持(0) 盖楼(回复)

支持(0) 盖楼(回复)