实例介绍

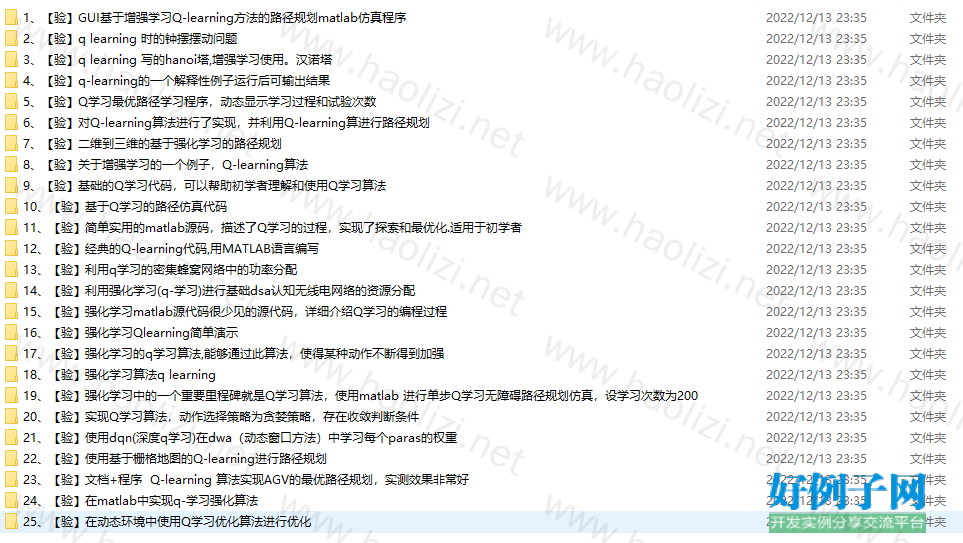

【实例简介】强化学习例程合集25inOne

适合初学者的强化学习例程,均为MATLAB编写

【实例截图】

【核心代码】

.

├── TPW Q-learning_25inONE

│ ├── 10、【验】基于Q学习的路径仿真代码

│ │ └── 基于Q学习的路径仿真代码

│ │ ├── QDemo.m

│ │ ├── Qlearning.m

│ │ └── drnd.m

│ ├── 11、【验】简单实用的matlab源码,描述了Q学习的过程,实现了探索和最优化.适用于初学者

│ │ └── Q-learning

│ │ ├── RandomPermutation.m

│ │ └── ReinforcementLearning.m

│ ├── 12、【验】经典的Q-learning代码,用MATLAB语言编写

│ │ └── ╛¡╡ΣQ-learng┤·┬δ

│ │ ├── Qlearning

│ │ │ ├── QDemo.m

│ │ │ ├── Qlearning.m

│ │ │ ├── ReadMe.txt

│ │ │ └── drnd.m

│ │ └── ReinforcementLearning.m

│ ├── 13、【验】利用q学习的密集蜂窝网络中的功率分配

│ │ └── 【验】利用q学习的密集蜂窝网络中的功率分配

│ │ └── proximity-master

│ │ ├── BaseStation.m

│ │ ├── FemtoStation.m

│ │ ├── FemtoStation_3S.m

│ │ ├── LogDistance.m

│ │ ├── PA_IL_CL.m

│ │ ├── PA_IL_CL2.m

│ │ ├── PA_IL_CL3.m

│ │ ├── PA_RL.m

│ │ ├── PA_RL_permutatedFemtocells.m

│ │ ├── PA_RL_ref.m

│ │ ├── README.md

│ │ ├── RandomPermutation.m

│ │ ├── SINR_FUE_2.m

│ │ ├── SINR_MUE_4.m

│ │ ├── UE.m

│ │ ├── allcomb.m

│ │ ├── drawPlots

│ │ │ ├── DrawGeographic.m

│ │ │ ├── meanOverResults.m

│ │ │ ├── timeComplexity.m

│ │ │ └── timesteps.m

│ │ ├── empiricalLoss.m

│ │ ├── measure_channel.m

│ │ ├── nearest_MUE.m

│ │ ├── npermutek.m

│ │ ├── parallel_R_pro.m

│ │ ├── parfor_progress.m

│ │ ├── pro_32_10_1.mat

│ │ ├── pro_32_11_1.mat

│ │ ├── pro_32_12_1.mat

│ │ ├── pro_32_13_1.mat

│ │ ├── pro_32_14_1.mat

│ │ ├── pro_32_15_1.mat

│ │ ├── pro_32_16_1.mat

│ │ ├── pro_32_1_1.mat

│ │ ├── pro_32_2_1.mat

│ │ ├── pro_32_3_1.mat

│ │ ├── pro_32_4_1.mat

│ │ ├── pro_32_5_1.mat

│ │ ├── pro_32_6_1.mat

│ │ ├── pro_32_7_1.mat

│ │ ├── pro_32_8_1.mat

│ │ ├── pro_32_9_1.mat

│ │ ├── proximity.m

│ │ ├── proximity_R3.m

│ │ ├── runForAll.m

│ │ ├── sarsa.m

│ │ ├── sarsa2.m

│ │ ├── textprogressbar.m

│ │ └── upperBound.m

│ ├── 14、【验】利用强化学习(q-学习)进行基础dsa认知无线电网络的资源分配

│ │ └── Resource-allocation-in-Cognitive-Radio

│ │ ├── AllTogether_New_Docitive.m

│ │ ├── README.md

│ │ ├── argmin_Q.m

│ │ ├── create_state_set.m

│ │ ├── find_idx.m

│ │ ├── findnearest.m

│ │ ├── get_distortion.m

│ │ ├── observe_state.m

│ │ ├── q_learning_allocation2.m

│ │ ├── randomize_G.m

│ │ ├── randomize_G2.m

│ │ ├── set_reqired_trans_rate.m

│ │ └── update_pu_sinr_level.m

│ ├── 15、【验】强化学习matlab源代码很少见的源代码,详细介绍Q学习的编程过程

│ │ └── 强化学习matlab源代码很少见的源代码,详细介绍Q学习的编程过程

│ │ └── Q_learning_Reinforcement_learning.m

│ ├── 16、【验】强化学习Qlearning简单演示

│ │ └── Q-learning

│ │ ├── WS_FTP.LOG

│ │ ├── action_selector.m

│ │ ├── global1.m

│ │ ├── global2.m

│ │ ├── global3.m

│ │ ├── global4.m

│ │ ├── jump_learn.m

│ │ ├── main.m

│ │ ├── pol_finder.m

│ │ ├── qlearn.m

│ │ └── state_finder.m

│ ├── 17、【验】强化学习的q学习算法,能够通过此算法,使得某种动作不断得到加强

│ │ ├── ReinforcementLearning.m

│ │ ├── learning1.m

│ │ ├── learning2.m

│ │ ├── learning3.m

│ │ └── learning4.m

│ ├── 18、【验】强化学习算法q learning

│ │ └── Reinforcment-Learning-With-Q-Learning

│ │ └── Matlab

│ │ ├── NN_upload_dynamic.mat

│ │ ├── NN_upload_static.mat

│ │ ├── Q-Table_upload_dynamic.mat

│ │ ├── Q-Table_upload_static.mat

│ │ ├── Q-tabell&stateSpace.txt

│ │ ├── actionList.m

│ │ ├── checkCrash.m

│ │ ├── circle.m

│ │ ├── circularMotion.m

│ │ ├── computeQEstimate.m

│ │ ├── createCarCircle.m

│ │ ├── createQTable.m

│ │ ├── createSimulation.m

│ │ ├── createStadium.m

│ │ ├── createStateSpace.m

│ │ ├── discretization.m

│ │ ├── doActionCircle.m

│ │ ├── funPause1.m

│ │ ├── funPause2.m

│ │ ├── funReset1.m

│ │ ├── funReset2.m

│ │ ├── funSave1.m

│ │ ├── funSave2.m

│ │ ├── funStart1.m

│ │ ├── funStart2.m

│ │ ├── funUpload1.m

│ │ ├── funUpload2.m

│ │ ├── getBestAction.m

│ │ ├── getReward.m

│ │ ├── gradientDescent.m

│ │ ├── initSimulation.m

│ │ ├── main.m

│ │ ├── moveCarCircle.m

│ │ ├── moveSensor.m

│ │ ├── nnBackPropagation.m

│ │ ├── nnEpsilonGreedyExploration.m

│ │ ├── nnFeedForward.m

│ │ ├── nnGetReward.m

│ │ ├── nnSoftMaxSelection.m

│ │ ├── nnTrials.m

│ │ ├── nnWeights.txt

│ │ ├── obstacleCrash.m

│ │ ├── randInitializeWeights.m

│ │ ├── sensorValues.m

│ │ ├── setprod.m

│ │ ├── softMaxSelection.m

│ │ ├── tableEpsilonGreedyExploration.m

│ │ ├── tableTrials.m

│ │ ├── tanhActivation.m

│ │ ├── tanhDerivative.m

│ │ └── updateQTable.m

│ ├── 19、【验】强化学习中的一个重要里程碑就是Q学习算法,使用matlab 进行单步Q学习无障碍路径规划仿真,设学习次数为200

│ │ └── matlab Q学习仿真

│ │ ├── QDemo.asv

│ │ ├── QDemo.m

│ │ ├── Qlearning.asv

│ │ ├── Qlearning.m

│ │ ├── ReadMe.txt

│ │ ├── drnd.asv

│ │ └── drnd.m

│ ├── 1、【验】GUI基于增强学习Q-learning方法的路径规划matlab仿真程序

│ │ └── Q-Learing路径规划MATLAB仿真

│ │ ├── 17-04-13.tif

│ │ ├── Activity.m

│ │ ├── InitrialQ.m

│ │ ├── InitrialQ_Poe.m

│ │ ├── MovRobot.m

│ │ ├── MyAlgorithm.m

│ │ ├── PathPlanning.fig

│ │ ├── PathPlanning.m

│ │ ├── PlotSTD.m

│ │ ├── PlotStats.m

│ │ ├── Replay.m

│ │ ├── Sensor.m

│ │ ├── exportfig.m

│ │ ├── filename.eps

│ │ ├── hs_err_pid4776.log

│ │ ├── inf.mat

│ │ ├── ndi2lin.m

│ │ ├── 说明.txt

│ │ └── 系统简介.txt

│ ├── 20、【验】实现Q学习算法,动作选择策略为贪婪策略,存在收敛判断条件

│ │ └── Q学习

│ │ ├── Qlearningmain.m

│ │ └── choose_action.m

│ ├── 21、【验】使用dqn(深度q学习)在dwa(动态窗口方法)中学习每个paras的权重

│ │ └── DQN_of_DWA_matlab-master

│ │ ├── Agent

│ │ │ ├── AgentLearn.m

│ │ │ ├── AgentOutput.m

│ │ │ ├── BackPro.m

│ │ │ ├── CreateNeuralNetneural.m

│ │ │ ├── ForwardPro.m

│ │ │ └── NetSetUp.m

│ │ ├── DQN.m

│ │ ├── Environment

│ │ │ ├── Environment.m

│ │ │ ├── GetCurSurOb.m

│ │ │ ├── GoalRandGen.m

│ │ │ ├── InitialState.m

│ │ │ └── LocalPathPlanning.m

│ │ ├── Ob.png

│ │ └── README.md

│ ├── 22、【验】使用基于栅格地图的Q-learning进行路径规划

│ │ └── Q.m

│ ├── 23、【验】文档 程序 Q-learning 算法实现AGV的最优路径规划,实测效果非常好

│ │ └── 【验】文档 程序 Q-learning 算法实现AGV的最优路径规划,实测效果非常好

│ │ ├── RandomPermutation.m

│ │ ├── ReinforcementLearning.docx

│ │ └── ReinforcementLearning.m

│ ├── 24、【验】在matlab中实现q-学习强化算法

│ │ └── Q-Learning-Algorithm-Implementation-in-MATLAB-master

│ │ ├── LICENSE

│ │ ├── README.md

│ │ ├── RandomPermutation.m

│ │ ├── ReinforcementLearningGreedy.m

│ │ ├── ReinforcementLearningUpdateR.m

│ │ ├── ReinforcementLearning_RandomPol.m

│ │ ├── RewardMatrix100.m

│ │ ├── RewardMatrix25.m

│ │ ├── RewardMatrixNoPunishment.csv

│ │ └── RewardMatrixPunishment.csv

│ ├── 25、【验】在动态环境中使用Q学习优化算法进行优化

│ │ └── The-Use-of-Q-learning-for-Optimization-in-Dynamic-Environments-master

│ │ ├── DEQ

│ │ │ ├── Constant_Basis_Function.m

│ │ │ ├── Peak_Function1.m

│ │ │ ├── Peak_Function_Cone.m

│ │ │ ├── change_peaks.m

│ │ │ ├── change_stepsize_linear.m

│ │ │ ├── change_stepsize_random.m

│ │ │ ├── current_peak_calc.m

│ │ │ ├── deq.m

│ │ │ ├── dummy_eval.m

│ │ │ ├── eval_movpeaks.m

│ │ │ ├── ffa_move.m

│ │ │ ├── findrange.m

│ │ │ ├── fitness.m

│ │ │ ├── free_peaks.m

│ │ │ ├── getCurrentPeak.m

│ │ │ ├── getMaxCoordinate.m

│ │ │ ├── getMaxHeight.m

│ │ │ ├── getMaximumPeak.m

│ │ │ ├── getMinCoordinate.m

│ │ │ ├── getPeakHeights.m

│ │ │ ├── getPeakPositions.m

│ │ │ ├── get_avg_error.m

│ │ │ ├── get_current_error.m

│ │ │ ├── get_number_of_evals.m

│ │ │ ├── get_offline_error.m

│ │ │ ├── get_offline_performance.m

│ │ │ ├── get_right_peak.m

│ │ │ ├── init_ffa.m

│ │ │ ├── init_parameters.m

│ │ │ ├── init_peaks.m

│ │ │ ├── main.m

│ │ │ ├── movpeaks.m

│ │ │ ├── printPeakData.m

│ │ │ ├── set_global.m

│ │ │ ├── startup.m

│ │ │ └── testtest.m

│ │ └── README.md

│ ├── 2、【验】q learning 时的钟摆摆动问题

│ │ └── MATLAB-Reinforcement-Learning-Pendulum

│ │ ├── QlearnPend.m

│ │ └── README.md

│ ├── 3、【验】q learning 写的hanoi塔,增强学习使用。汉诺塔

│ │ └── qhanoi

│ │ ├── fillin.m

│ │ ├── iter.m

│ │ ├── output.m

│ │ ├── printState.m

│ │ └── qhanoi.m

│ ├── 4、【验】q-learning的一个解释性例子运行后可输出结果

│ │ └── q-learning的一个解释性例子运行后可输出结果

│ │ ├── RandomPermutation.m

│ │ └── ReinforcementLearning.m

│ ├── 5、【验】Q学习最优路径学习程序,动态显示学习过程和试验次数

│ │ └── QDemo.m

│ ├── 6、【验】对Q-learning算法进行了实现,并利用Q-learning算进行路径规划

│ │ └── Reinforcment-Learning-With-Q-Learning-master

│ │ └── Matlab

│ │ ├── NN_upload_dynamic.mat

│ │ ├── NN_upload_static.mat

│ │ ├── Q-Table_upload_dynamic.mat

│ │ ├── Q-Table_upload_static.mat

│ │ ├── Q-tabell&stateSpace.txt

│ │ ├── actionList.m

│ │ ├── checkCrash.m

│ │ ├── circle.m

│ │ ├── circularMotion.m

│ │ ├── computeQEstimate.m

│ │ ├── createCarCircle.m

│ │ ├── createQTable.m

│ │ ├── createSimulation.m

│ │ ├── createStadium.m

│ │ ├── createStateSpace.m

│ │ ├── discretization.m

│ │ ├── doActionCircle.m

│ │ ├── funPause1.m

│ │ ├── funPause2.m

│ │ ├── funReset1.m

│ │ ├── funReset2.m

│ │ ├── funSave1.m

│ │ ├── funSave2.m

│ │ ├── funStart1.m

│ │ ├── funStart2.m

│ │ ├── funUpload1.m

│ │ ├── funUpload2.m

│ │ ├── getBestAction.m

│ │ ├── getReward.m

│ │ ├── gradientDescent.m

│ │ ├── initSimulation.m

│ │ ├── main.m

│ │ ├── moveCarCircle.m

│ │ ├── moveSensor.m

│ │ ├── nnBackPropagation.m

│ │ ├── nnEpsilonGreedyExploration.m

│ │ ├── nnFeedForward.m

│ │ ├── nnGetReward.m

│ │ ├── nnSoftMaxSelection.m

│ │ ├── nnTrials.m

│ │ ├── nnWeights.txt

│ │ ├── obstacleCrash.m

│ │ ├── randInitializeWeights.m

│ │ ├── sensorValues.m

│ │ ├── setprod.m

│ │ ├── softMaxSelection.m

│ │ ├── tableEpsilonGreedyExploration.m

│ │ ├── tableTrials.m

│ │ ├── tanhActivation.m

│ │ ├── tanhDerivative.m

│ │ └── updateQTable.m

│ ├── 7、【验】二维到三维的基于强化学习的路径规划

│ │ └── Q-learning

│ │ ├── Untitle2d.m

│ │ ├── Untitled.m

│ │ ├── Untitled122.m

│ │ ├── Untitled2.m

│ │ ├── Untitled3333.m

│ │ ├── Untitled3333222.m

│ │ ├── dd.jpg

│ │ ├── ddd.jpg

│ │ ├── erwei.m

│ │ ├── findmaxx.m

│ │ ├── huatu.m

│ │ ├── jjj.jpg

│ │ ├── jpp.jpg

│ │ ├── luji.jpg

│ │ ├── lujibianhua.jpg

│ │ ├── nihe.m

│ │ ├── untitled.jpg

│ │ ├── wert.m

│ │ ├── xxx.mat

│ │ ├── zhixian.m

│ │ ├── zui.mat

│ │ ├── zzz.mat

│ │ ├── 微信截图_20201227013004.png

│ │ └── 微信图片_20201228075443.png

│ ├── 8、【验】关于增强学习的一个例子,Q-learning算法

│ │ └── Q-learning

│ │ ├── WS_FTP.LOG

│ │ ├── action_selector.m

│ │ ├── global1.m

│ │ ├── global2.m

│ │ ├── global3.m

│ │ ├── global4.m

│ │ ├── jump_learn.m

│ │ ├── main.m

│ │ ├── pol_finder.m

│ │ ├── qlearn.m

│ │ └── state_finder.m

│ └── 9、【验】基础的Q学习代码,可以帮助初学者理解和使用Q学习算法

│ └── Q-Learning.m

└── 强化学习例程合集25inOne_MATLAB_Q-learning_25inONE.rar

55 directories, 331 files

小贴士

感谢您为本站写下的评论,您的评论对其它用户来说具有重要的参考价值,所以请认真填写。

- 类似“顶”、“沙发”之类没有营养的文字,对勤劳贡献的楼主来说是令人沮丧的反馈信息。

- 相信您也不想看到一排文字/表情墙,所以请不要反馈意义不大的重复字符,也请尽量不要纯表情的回复。

- 提问之前请再仔细看一遍楼主的说明,或许是您遗漏了。

- 请勿到处挖坑绊人、招贴广告。既占空间让人厌烦,又没人会搭理,于人于己都无利。

关于好例子网

本站旨在为广大IT学习爱好者提供一个非营利性互相学习交流分享平台。本站所有资源都可以被免费获取学习研究。本站资源来自网友分享,对搜索内容的合法性不具有预见性、识别性、控制性,仅供学习研究,请务必在下载后24小时内给予删除,不得用于其他任何用途,否则后果自负。基于互联网的特殊性,平台无法对用户传输的作品、信息、内容的权属或合法性、安全性、合规性、真实性、科学性、完整权、有效性等进行实质审查;无论平台是否已进行审查,用户均应自行承担因其传输的作品、信息、内容而可能或已经产生的侵权或权属纠纷等法律责任。本站所有资源不代表本站的观点或立场,基于网友分享,根据中国法律《信息网络传播权保护条例》第二十二与二十三条之规定,若资源存在侵权或相关问题请联系本站客服人员,点此联系我们。关于更多版权及免责申明参见 版权及免责申明

网友评论

我要评论