实例介绍

【实例简介】强化学习 第2版 MATLAB代码

由John Weatherwax复现

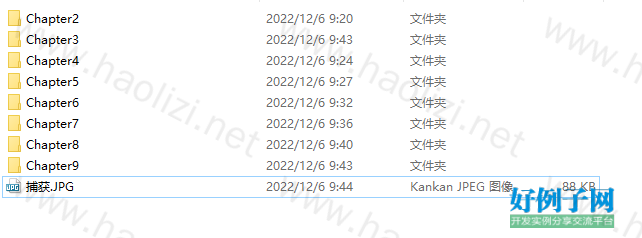

【实例截图】

【核心代码】

.

├── Reinforcement Learning by Sutton-MATLAB code_108m_9JPG

│ ├── Chapter2

│ │ ├── 1

│ │ │ └── sample_discrete.m

│ │ ├── 10. Pursuit Methods

│ │ │ ├── persuit_method.m

│ │ │ ├── persuit_method_Script.m

│ │ │ └── persuit_method_results.html

│ │ ├── 2

│ │ │ ├── n_armed_testbed.m

│ │ │ └── n_armed_testbed_results.html

│ │ ├── 3

│ │ │ ├── n_armed_testbed_softmax.m

│ │ │ └── n_armed_testbed_softmax_results.html

│ │ ├── 4.The Binary Bandit

│ │ │ ├── binary_bandit_exps.m

│ │ │ ├── binary_bandit_exps_Script.m

│ │ │ └── binary_bandit_results.html

│ │ ├── 5. Exercise 2.5

│ │ │ ├── exercise_2_5.m

│ │ │ └── exercise_2_5_results.html

│ │ ├── 6. Exercise 2.7

│ │ │ ├── exercise_2_7.m

│ │ │ ├── exercise_2_7_Script.m

│ │ │ └── exercise_2_7_results.html

│ │ ├── 7. Optimistic Initial Value

│ │ │ ├── opt_initial_values.m

│ │ │ ├── opt_initial_values_Script.m

│ │ │ └── opt_initial_values_results.html

│ │ ├── 8. Reinforcement Comparison Methods

│ │ │ ├── reinforcement_comparison_methods.m

│ │ │ ├── reinforcement_comparison_methods_Script.m

│ │ │ └── reinforment_comparison_methods_results.html

│ │ ├── 9. Exercise 2.11

│ │ │ ├── exercise_2_11.m

│ │ │ ├── exercise_2_11_Script.m

│ │ │ └── exercise_2_11_results.html

│ │ └── 捕获.JPG

│ ├── Chapter3

│ │ ├── 1. Numerically Solving the Bellman Equation for the Recycling Robot

│ │ │ ├── rr_action_bellman.m

│ │ │ └── rr_state_bellman.m

│ │ └── 捕获.JPG

│ ├── Chapter4

│ │ ├── 1. Policy Iteration for the Grid World Exampl

│ │ │ ├── iter_poly_gw_inplace.m

│ │ │ └── iter_poly_gw_not_inplace.m

│ │ ├── 2. Exercise 4.2 (Adding a state to grid world)

│ │ │ └── ex_4_2_sys_solv.m

│ │ ├── 3. Policy Improvement for the Jacks Car Rental (JCR) Example

│ │ │ ├── cmpt_P_and_R.m

│ │ │ ├── jcr_example.m

│ │ │ ├── jcr_policy_evaluation.m

│ │ │ ├── jcr_policy_improvement.m

│ │ │ └── jcr_rhs_state_value_bellman.m

│ │ ├── 4. Exercise 4.5 (Modifications on the Jacks Car Rental Example)

│ │ │ ├── ex_4_5_Script.m

│ │ │ ├── ex_4_5_policy_evaluation.m

│ │ │ ├── ex_4_5_policy_improvement.m

│ │ │ ├── ex_4_5_results.html

│ │ │ └── ex_4_5_rhs_state_value_bellman.m

│ │ ├── 5. The Gambler's Problem

│ │ │ ├── gam_Script.m

│ │ │ ├── gam_results.html

│ │ │ └── gam_rhs_state_bellman.m

│ │ └── 捕获.JPG

│ ├── Chapter5

│ │ ├── 1. Computing the State-Value function for the using the First-Visit Monte Carlo Method (for blackjack)

│ │ │ ├── bj_results.html

│ │ │ ├── cmpt_bj_value_fn.m

│ │ │ ├── determineReward.m

│ │ │ ├── handValue.m

│ │ │ ├── shufflecards.m

│ │ │ └── stateFromHand.m

│ │ ├── 2. Exploring Starts to compute the optimal policy for Blackjack

│ │ │ ├── mc_es_bj_Script.m

│ │ │ └── op_bj_results.html

│ │ ├── 3. Soft Policy Evaluation to compute the optimal policy for Blackjack

│ │ │ ├── soft_policy_bj_Script.m

│ │ │ └── soft_policy_bj_results.html

│ │ ├── 4. Exercise 5.4 (The Race Track Example)

│ │ │ ├── ex_5_4_Script.m

│ │ │ ├── gen_rt_episode.m

│ │ │ ├── init_unif_policy.m

│ │ │ ├── mcEstQ.m

│ │ │ ├── mk_rt.m

│ │ │ ├── rt_pol_mod.m

│ │ │ ├── rt_results.html

│ │ │ └── velState2PosActions.m

│ │ └── 捕获.JPG

│ ├── Chapter6

│ │ ├── 1. Comparing TD(0) and constant alpha MC learning on the Random Walk Example

│ │ │ ├── cmpt_arms_err.m

│ │ │ ├── eg_6_2_learn.m

│ │ │ ├── eg_rw_batch_learn.m

│ │ │ ├── fig_6_6_n_7_results.html

│ │ │ ├── fig_6_8_results.html

│ │ │ ├── mk_arms_error_plt.m

│ │ │ ├── mk_batch_arms_error_plt.m

│ │ │ └── mk_fig_6_6.m

│ │ ├── 2. The Windy Gridworld Example

│ │ │ ├── gw_results.html

│ │ │ ├── plot_gw_policy.m

│ │ │ ├── run_all_gw_Script.m

│ │ │ ├── wgw_w_kings.m

│ │ │ ├── wgw_w_kings_Script.m

│ │ │ ├── wgw_w_kings_n_wind.m

│ │ │ ├── wgw_w_kings_n_wind_Script.m

│ │ │ ├── wgw_w_stoch_wind.m

│ │ │ ├── wgw_w_stoch_wind_Script.m

│ │ │ ├── windy_gw.m

│ │ │ └── windy_gw_Script.m

│ │ ├── 3. The Cliff Walk example

│ │ │ ├── cw_results.html

│ │ │ ├── learn_cw.m

│ │ │ ├── learn_cw_Script.m

│ │ │ └── plot_cw_policy.m

│ │ ├── 4. The R learning example

│ │ │ ├── R_learn_acq.m

│ │ │ ├── R_learn_acq_Script.m

│ │ │ └── r_learn_results.html

│ │ └── 捕获.JPG

│ ├── Chapter7

│ │ ├── 1. Using TD(n) learning to learn random walks

│ │ │ ├── ntd_results.html

│ │ │ ├── rw_episode.m

│ │ │ ├── rw_offline_ntd_learn.m

│ │ │ ├── rw_offline_ntd_learn_Script.m

│ │ │ ├── rw_online_ntd_learn.m

│ │ │ └── rw_online_ntd_learn_Script.m

│ │ ├── 2. Using TD(lambda) learning to learn random walks

│ │ │ ├── rw_offline_tdl_learn.m

│ │ │ ├── rw_offline_tdl_learn_Script.m

│ │ │ ├── rw_online_tdl_learn.m

│ │ │ ├── rw_online_tdl_learn_Script.m

│ │ │ └── tdl_results.html

│ │ ├── 3. Online TD(lambda) with eligability traces

│ │ │ ├── rw_online_w_et.m

│ │ │ ├── rw_online_w_et_Script.m

│ │ │ └── tdl_w_et_results.html

│ │ ├── 4. Example 7.4 Implementing the Grid World example with eligability traces

│ │ │ ├── gw_w_et.m

│ │ │ └── gw_w_et_Script.m

│ │ ├── 5. Accumulating traces v.s. Replacing traces

│ │ │ ├── acc_vs_rep_results.html

│ │ │ ├── rw_accumulating_vs_replacing_Script.m

│ │ │ └── rw_online_w_replacing_traces.m

│ │ ├── 6. Example 7.5 Learning from a one directional Markov chain

│ │ │ ├── eg_7_5_Script.m

│ │ │ ├── eg_7_5_episode.m

│ │ │ ├── eg_7_5_learn_at.m

│ │ │ ├── eg_7_5_learn_rt.m

│ │ │ └── eg_7_5_results.html

│ │ └── 捕获.JPG

│ ├── Chapter8

│ │ ├── 1. Using Coarse Coding to Approximate a Step Function

│ │ │ ├── coarse_coding_results.html

│ │ │ ├── linAppFn.m

│ │ │ ├── stp_fn_approx_Script.m

│ │ │ └── targetF.m

│ │ ├── 2. The Mountain Car Example

│ │ │ ├── (1) Driver scripts to run the examples (run GetTiles_Mex_Script.m to create the needed MEX interface to GetTiles)

│ │ │ │ ├── GetTiles_Mex_Script.m

│ │ │ │ └── mnt_car_learn_Script.m

│ │ │ ├── (2) Sample output produced from the above codes (plot of -max_a Q_t(s,a))

│ │ │ │ └── mt_results.html

│ │ │ └── (3) Component code called from the above driver functions

│ │ │ ├── GetTiles_Mex.C

│ │ │ ├── get_ctg.m

│ │ │ ├── mnt_car_learn.m

│ │ │ ├── next_state.m

│ │ │ ├── ret_q_in_st.m

│ │ │ ├── tiles.C

│ │ │ └── tiles.h

│ │ ├── 3. Learning Rates for the Mountain Car Example (Replacement vs. Accumulate Traces)

│ │ │ ├── do_mnt_car_Exps.m

│ │ │ └── mt_learning_rate_results.html

│ │ └── 捕获.JPG

│ ├── Chapter9

│ │ ├── 1. A Comparison of the number of planning steps in Dyna maze planning

│ │ │ ├── do_ex_9_1_exps.m

│ │ │ ├── dynaQ_maze.m

│ │ │ ├── dynaQ_maze_Script.m

│ │ │ ├── dyna_maze_planning.html

│ │ │ ├── mk_ex_9_1_mz.m

│ │ │ └── plot_mz_policy.m

│ │ ├── 2. The blocking maze example

│ │ │ ├── blocking_maze_planning.html

│ │ │ ├── blocking_mz_Script.m

│ │ │ ├── dynaQplus_maze.m

│ │ │ ├── dynaQplus_maze_Script.m

│ │ │ └── mk_ex_9_2_mz.m

│ │ ├── 3. The shortcut maze

│ │ │ ├── mk_ex_9_3_mz.m

│ │ │ └── shortcut_maze_planning.html

│ │ ├── 4. Exercise 9.4

│ │ │ ├── ex_9_4_dynaQplus.m

│ │ │ ├── ex_9_4_dynaQplus_Script.m

│ │ │ └── ex_9_4_results.html

│ │ └── 捕获.JPG

│ └── 捕获.JPG

└── 强化学习 第2版 MATLAB代码_ReinforcementLearningbySutton-MATLABcode.zip

49 directories, 153 files

小贴士

感谢您为本站写下的评论,您的评论对其它用户来说具有重要的参考价值,所以请认真填写。

- 类似“顶”、“沙发”之类没有营养的文字,对勤劳贡献的楼主来说是令人沮丧的反馈信息。

- 相信您也不想看到一排文字/表情墙,所以请不要反馈意义不大的重复字符,也请尽量不要纯表情的回复。

- 提问之前请再仔细看一遍楼主的说明,或许是您遗漏了。

- 请勿到处挖坑绊人、招贴广告。既占空间让人厌烦,又没人会搭理,于人于己都无利。

关于好例子网

本站旨在为广大IT学习爱好者提供一个非营利性互相学习交流分享平台。本站所有资源都可以被免费获取学习研究。本站资源来自网友分享,对搜索内容的合法性不具有预见性、识别性、控制性,仅供学习研究,请务必在下载后24小时内给予删除,不得用于其他任何用途,否则后果自负。基于互联网的特殊性,平台无法对用户传输的作品、信息、内容的权属或合法性、安全性、合规性、真实性、科学性、完整权、有效性等进行实质审查;无论平台是否已进行审查,用户均应自行承担因其传输的作品、信息、内容而可能或已经产生的侵权或权属纠纷等法律责任。本站所有资源不代表本站的观点或立场,基于网友分享,根据中国法律《信息网络传播权保护条例》第二十二与二十三条之规定,若资源存在侵权或相关问题请联系本站客服人员,点此联系我们。关于更多版权及免责申明参见 版权及免责申明

网友评论

我要评论